[ English | русский | Deutsch | Indonesia | English (United Kingdom) ]

Beispiel für eine Testumgebung¶

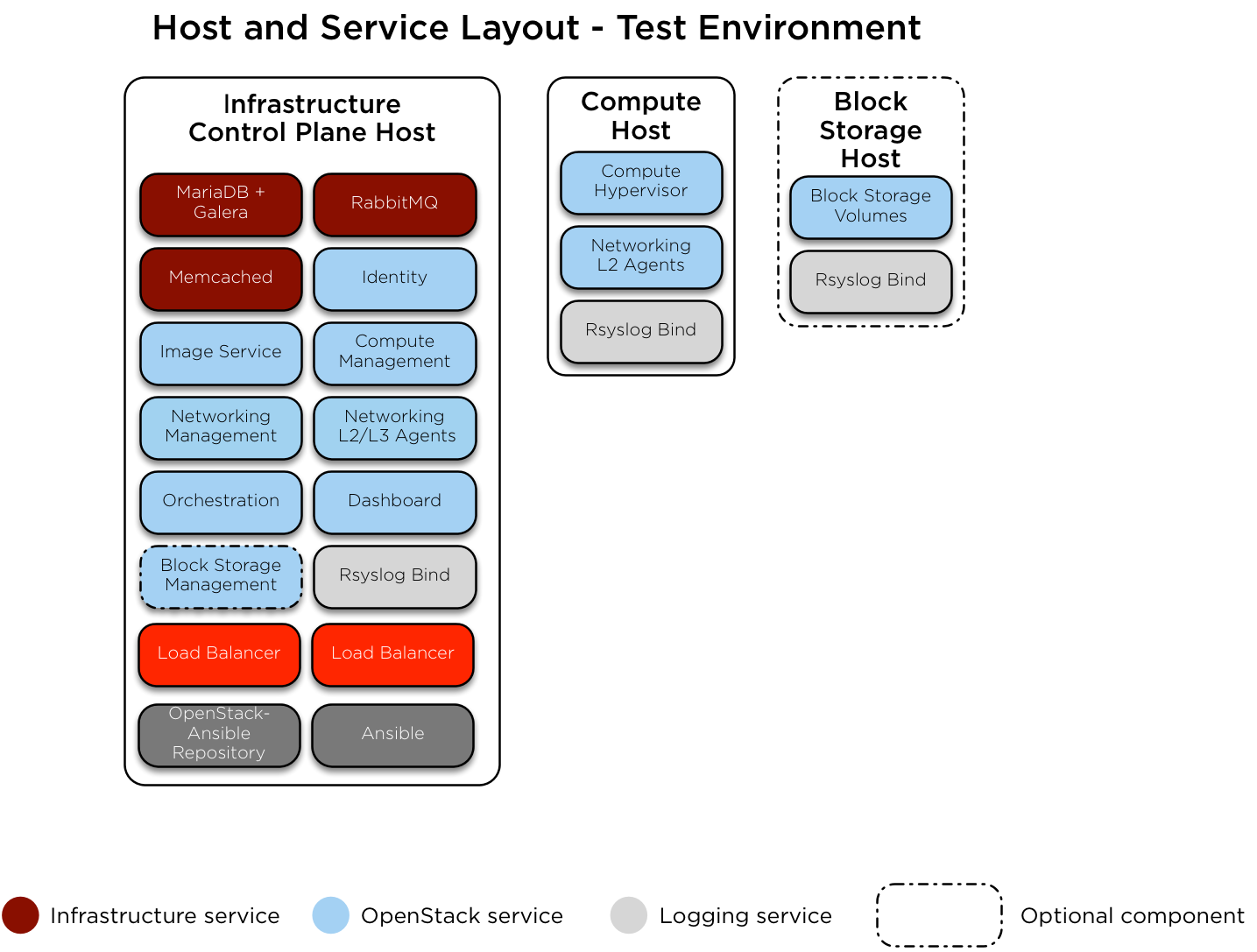

Hier sehen Sie eine Beispiel-Testumgebung für eine funktionierende OpenStack-Ansible (OSA) -Implementierung mit einer kleinen Anzahl von Servern.

Diese Beispielumgebung weist die folgenden Merkmale auf:

Ein Host der Infrastruktur (Kontrollebene) (8 vCPU, 8 GB RAM, 60 GB HDD)

Ein Rechner (8 vCPU, 8 GB RAM, 60 GB HDD)

Eine Netzwerkkarte (NIC) für jeden Host

Eine grundlegende Compute-Kit-Umgebung mit den Diensten Image (glance) und Compute (nova) zur Verwendung von dateiunterstütztem Speicher.

Internetzugang über die Router-Adresse 172.29.236.1 im Management-Netzwerk

Netzwerkkonfiguration¶

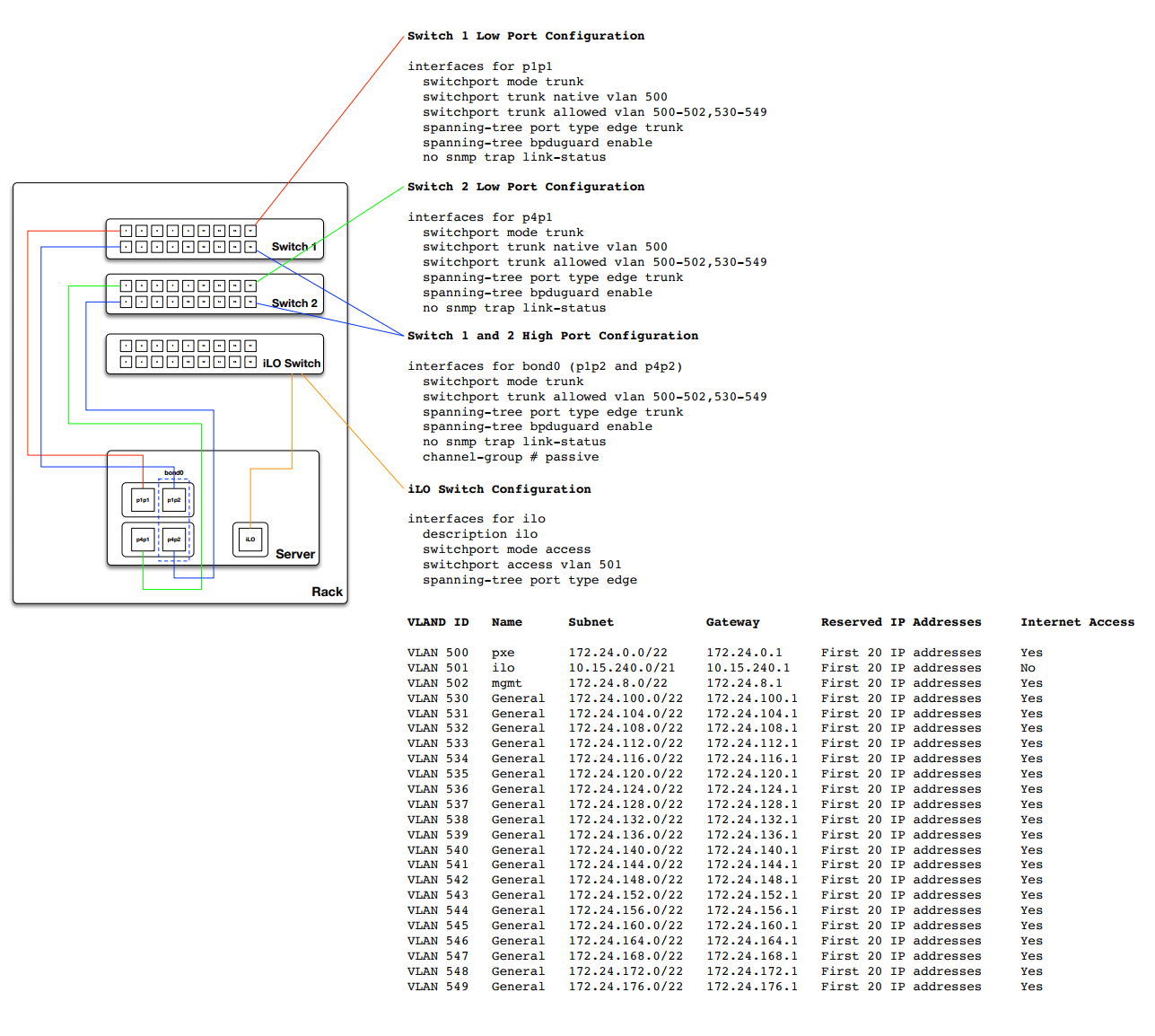

Wechseln Sie die Portkonfiguration¶

Das folgende Beispiel bietet eine gute Referenz für die Schalterkonfiguration und das Kabinenlayout. Dieses Beispiel kann mehr sein als das, was für grundlegende Setups erforderlich ist, es kann jedoch an fast jede Konfiguration angepasst werden. Außerdem müssen Sie die in diesem Beispiel angegebenen VLANs an Ihre Umgebung anpassen.

Netzwerk CIDR / VLAN Zuweisungen¶

Die folgenden CIDR- und VLAN-Zuweisungen werden für diese Umgebung verwendet.

Netzwerk |

CIDR |

VLAN |

|---|---|---|

Verwaltungsnetzwerk |

172.29.236.0/22 |

10 |

Tunnel (VXLAN) Netzwerk |

172.29.240.0/22 |

30 |

Speichernetzwerk |

172.29.244.0/22 |

20 |

IP-Zuweisungen¶

Die folgenden Hostnamen und IP-Adresszuweisungen werden für diese Umgebung verwendet.

Hostname |

Verwaltungs-IP |

Tunnel (VXLAN) IP |

Speicher-IP |

|---|---|---|---|

infra1 |

172.29.236.11 |

172.29.240.11 |

|

compute1 |

172.29.236.12 |

172.29.240.12 |

172.29.244.12 |

Speicher1 |

172.29.236.13 |

172.29.244.13 |

Host-Netzwerkkonfiguration¶

Für jeden Host müssen die richtigen Netzwerkbrücken implementiert werden. Das Folgende ist die /etc/network/interfaces Datei für `` infra1``.

Bemerkung

Wenn Ihre Umgebung nicht eth0, sondern p1p1 oder einen anderen Namen hat, stellen Sie sicher, dass alle Verweise auf eth0 in allen Konfigurationsdateien durch den entsprechenden Namen ersetzt werden. Gleiches gilt für zusätzliche Netzwerkschnittstellen.

# This is a single-NIC configuration to implement the required bridges

# for OpenStack-Ansible. This illustrates the configuration of the first

# Infrastructure host and the IP addresses assigned should be adapted

# for implementation on the other hosts.

#

# After implementing this configuration, the host will need to be

# rebooted.

# Physical interface

auto eth0

iface eth0 inet manual

# Container/Host management VLAN interface

auto eth0.10

iface eth0.10 inet manual

vlan-raw-device eth0

# OpenStack Networking VXLAN (tunnel/overlay) VLAN interface

auto eth0.30

iface eth0.30 inet manual

vlan-raw-device eth0

# Storage network VLAN interface (optional)

auto eth0.20

iface eth0.20 inet manual

vlan-raw-device eth0

# Container/Host management bridge

auto br-mgmt

iface br-mgmt inet static

bridge_stp off

bridge_waitport 0

bridge_fd 0

bridge_ports eth0.10

address 172.29.236.11

netmask 255.255.252.0

gateway 172.29.236.1

dns-nameservers 8.8.8.8 8.8.4.4

# Bind the External VIP

auto br-mgmt:0

iface br-mgmt:0 inet static

address 172.29.236.10

netmask 255.255.252.0

# OpenStack Networking VXLAN (tunnel/overlay) bridge

#

# The COMPUTE, NETWORK and INFRA nodes must have an IP address

# on this bridge.

#

auto br-vxlan

iface br-vxlan inet static

bridge_stp off

bridge_waitport 0

bridge_fd 0

bridge_ports eth0.30

address 172.29.240.11

netmask 255.255.252.0

# OpenStack Networking VLAN bridge

auto br-vlan

iface br-vlan inet manual

bridge_stp off

bridge_waitport 0

bridge_fd 0

bridge_ports eth0

# compute1 Network VLAN bridge

#auto br-vlan

#iface br-vlan inet manual

# bridge_stp off

# bridge_waitport 0

# bridge_fd 0

#

# For tenant vlan support, create a veth pair to be used when the neutron

# agent is not containerized on the compute hosts. 'eth12' is the value used on

# the host_bind_override parameter of the br-vlan network section of the

# openstack_user_config example file. The veth peer name must match the value

# specified on the host_bind_override parameter.

#

# When the neutron agent is containerized it will use the container_interface

# value of the br-vlan network, which is also the same 'eth12' value.

#

# Create veth pair, do not abort if already exists

# pre-up ip link add br-vlan-veth type veth peer name eth12 || true

# Set both ends UP

# pre-up ip link set br-vlan-veth up

# pre-up ip link set eth12 up

# Delete veth pair on DOWN

# post-down ip link del br-vlan-veth || true

# bridge_ports eth0 br-vlan-veth

# Storage bridge (optional)

#

# Only the COMPUTE and STORAGE nodes must have an IP address

# on this bridge. When used by infrastructure nodes, the

# IP addresses are assigned to containers which use this

# bridge.

#

auto br-storage

iface br-storage inet manual

bridge_stp off

bridge_waitport 0

bridge_fd 0

bridge_ports eth0.20

# compute1 Storage bridge

#auto br-storage

#iface br-storage inet static

# bridge_stp off

# bridge_waitport 0

# bridge_fd 0

# bridge_ports eth0.20

# address 172.29.244.12

# netmask 255.255.252.0

Bereitstellungskonfiguration¶

Umgebungslayout¶

Die Datei /etc/openstack_deploy/openstack_user_config.yml definiert das Umgebungslayout.

Die folgende Konfiguration beschreibt das Layout für diese Umgebung.

---

cidr_networks:

management: 172.29.236.0/22

tunnel: 172.29.240.0/22

storage: 172.29.244.0/22

used_ips:

- "172.29.236.1,172.29.236.50"

- "172.29.240.1,172.29.240.50"

- "172.29.244.1,172.29.244.50"

- "172.29.248.1,172.29.248.50"

global_overrides:

# The internal and external VIP should be different IPs, however they

# do not need to be on separate networks.

external_lb_vip_address: 172.29.236.10

internal_lb_vip_address: 172.29.236.11

management_bridge: "br-mgmt"

provider_networks:

- network:

container_bridge: "br-mgmt"

container_type: "veth"

container_interface: "eth1"

ip_from_q: "management"

type: "raw"

group_binds:

- all_containers

- hosts

is_management_address: true

- network:

container_bridge: "br-vxlan"

container_type: "veth"

container_interface: "eth10"

ip_from_q: "tunnel"

type: "vxlan"

range: "1:1000"

net_name: "vxlan"

group_binds:

- neutron_openvswitch_agent

- network:

container_bridge: "br-vlan"

container_type: "veth"

container_interface: "eth12"

host_bind_override: "eth12"

type: "flat"

net_name: "physnet1"

group_binds:

- neutron_openvswitch_agent

- network:

container_bridge: "br-vlan"

container_type: "veth"

container_interface: "eth11"

type: "vlan"

range: "101:200,301:400"

net_name: "physnet2"

group_binds:

- neutron_openvswitch_agent

- network:

container_bridge: "br-storage"

container_type: "veth"

container_interface: "eth2"

ip_from_q: "storage"

type: "raw"

group_binds:

- glance_api

- cinder_api

- cinder_volume

- nova_compute

###

### Infrastructure

###

# galera, memcache, rabbitmq, utility

shared-infra_hosts:

infra1:

ip: 172.29.236.11

# repository (apt cache, python packages, etc)

repo-infra_hosts:

infra1:

ip: 172.29.236.11

# load balancer

load_balancer_hosts:

infra1:

ip: 172.29.236.11

###

### OpenStack

###

# keystone

identity_hosts:

infra1:

ip: 172.29.236.11

# cinder api services

storage-infra_hosts:

infra1:

ip: 172.29.236.11

# glance

image_hosts:

infra1:

ip: 172.29.236.11

# placement

placement-infra_hosts:

infra1:

ip: 172.29.236.11

# nova api, conductor, etc services

compute-infra_hosts:

infra1:

ip: 172.29.236.11

# heat

orchestration_hosts:

infra1:

ip: 172.29.236.11

# horizon

dashboard_hosts:

infra1:

ip: 172.29.236.11

# neutron server, agents (L3, etc)

network_hosts:

infra1:

ip: 172.29.236.11

# nova hypervisors

compute_hosts:

compute1:

ip: 172.29.236.12

# cinder storage host (LVM-backed)

storage_hosts:

storage1:

ip: 172.29.236.13

container_vars:

cinder_backends:

limit_container_types: cinder_volume

lvm:

volume_group: cinder-volumes

volume_driver: cinder.volume.drivers.lvm.LVMVolumeDriver

volume_backend_name: LVM_iSCSI

iscsi_ip_address: "172.29.244.13"

Umgebungsanpassungen¶

Die optional bereitgestellten Dateien in /etc/openstack_deploy/env.d ermöglichen die Anpassung von Ansible-Gruppen. Dadurch kann der Deployer festlegen, ob die Dienste in einem Container (Standard) oder auf dem Host (auf Metall) ausgeführt werden.

Für diese Umgebung benötigen Sie den Ordner /etc/openstack_deploy/env.d nicht, da die von OpenStack-Ansible vorgegebenen Voreinstellungen dafür geeignet sind.

Benutzervariablen¶

Die Datei /etc/openstack_deploy/user_variables.yml definiert die globalen Überschreibungen für die Standardvariablen.

Wenn Sie für diese Umgebung dieselbe IP-Adresse für die internen und externen Endpunkte verwenden möchten, müssen Sie sicherstellen, dass die internen und öffentlichen OpenStack-Endpunkte mit demselben Protokoll bedient werden. Dies geschieht mit folgendem Inhalt:

---

# This file contains an example of the global variable overrides

# which may need to be set for a production environment.

## OpenStack public endpoint protocol

openstack_service_publicuri_proto: http